1. ec2 - jenkins 설치

jenkins 설치를 위해 사이즈를 기존 default 사이즈가 아닌 t2 large 로

*보안그룹은 jenkins 가 들어올 포트와 alb 포트 가 필요 하다. 프리티어 계정이라 패스

접속 이후 에는

관리자 권한으로 변경 이후 yum update 진행

jenkins 설치

sudo wget -O /etc/yum.repos.d/jenkins.repo https://pkg.jenkins.io/redhat-stable/jenkins.repo

sudo rpm --import https://pkg.jenkins.io/redhat-stable/jenkins.io.key

sudo yum install -y jenkins

jenkins 설치 확인

rpm -qa | grep jenkins

node js 설치

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.34.0/install.sh | bash

. ~/.nvm/nvm.sh

nvm install 16 실습 code 는 node 16

java maven 설치

yum install -y java java-devel maven

## git

yum install -y git

## ansible

yum install ansible

(amazon-linux-extras X)sudo amazon-linux-extras install -y ansible2

# 배포 서버에 nginx

yum install nginx -y

(amazon-linux-extras X)sudo amazon-linux-extras install -y nginx1

# 젠킨스시작

systemctl start Jenkins

* 실패 시 yum update

* systemctl enable jenkins

* systemctl start jenkins

* journalctl -u jenkins

** java version 수정

wget https://github.com/AdoptOpenJDK/openjdk8-upstream-binaries/releases/download/jdk8u292-b10/OpenJDK8U-jdk_x64_linux_8u292b10.tar.gz

#젠킨스 실행확인

ps-ef | grep jenkins

아래 자바 버전 변경 참조 ( javac 도 동일한 방법으로 변경 가능)

https://velog.io/@mcyoo/AWS-EC2-JAVA-%EB%B2%84%EC%A0%84-%EB%B0%94%EA%BE%B8%EA%B8%B0

최종 실행 시 아래와 같은 화면 확인 가능

이미지 안에 경로 복사하여

cat 명령어로 패스워드 확인가능

권장설치 선택

계정 생성 이후 우리가 알던 그 젠킨스 확인 가능

jenkins node 설치아후 툴 설정에서 nodejs 추가

jenkins 파이프라인 설정

스크립트 작성

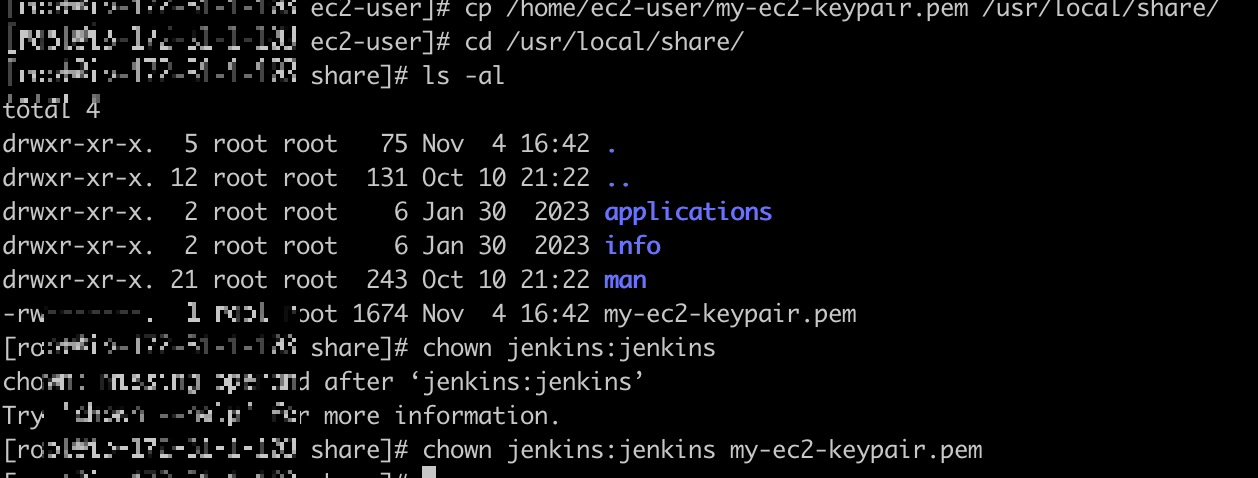

ec2 key jenkins 서버 업로드

프로그램 사용 혹은 아래 명령어 통해서 업로드

scp -i ~/Downloads/my-ec2-keypair.pem ~/Downloads/my-ec2-keypair.pem ec2-user@my-ip:/home/ec2-user

이후 jenkins 사용 할 수 있도록 파일 이동 및 권한 소유주 변경

이후 젠킨스 빌드

'인강 정리 > DevOps & MSA' 카테고리의 다른 글

| 소규모시스템 구축(5) (0) | 2024.10.21 |

|---|---|

| 소규모시스템 구축(4) (1) | 2024.10.19 |

| 소규모시스템 구축(3) (2) | 2024.10.18 |

| 소규모시스템구축(2) (1) | 2024.08.01 |

| 소규모시스템 구축(1) (1) | 2024.08.01 |